4번 문제는 코드를 작성하는 게 아닌 이론적으로 설명하는 문제이다.

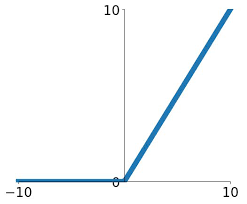

relu

0보다 크면 그 값을 그대로 쓰고 0보다 작으면 0을 사용하는 활성화 함수.

max(0,x) 입력이 음수인 경우 계속 0이 되어 dying Relu 가 발생한다.

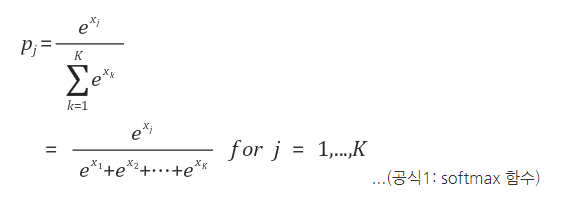

softmax

주로 output을 0~1 사이 값으로 정규화하여 주로 확률값으로 나타내는 경우에 사용하는 활성화 함수.

'DAFIT > 902 - 딥러닝으로 은하분류하기' 카테고리의 다른 글

| <DAFIT> 02 딥러닝으로 은하 분류하기 06 - Validation, Evaluate (0) | 2019.10.29 |

|---|---|

| <DAFIT> 02 딥러닝으로 은하 분류하기 05 - Loss, Optimizer (0) | 2019.10.29 |

| <DAFIT> 02 딥러닝으로 은하 분류하기 03 - CNN (0) | 2019.10.29 |

| <DAFIT> 02 딥러닝으로 은하 분류하기 02 - Image Data Generator (0) | 2019.10.29 |

| <DAFIT> 02 딥러닝으로 은하 분류하기 01 - Import (0) | 2019.10.29 |